DouZero

DMC

MC + DNN(Q-table) = > DMC

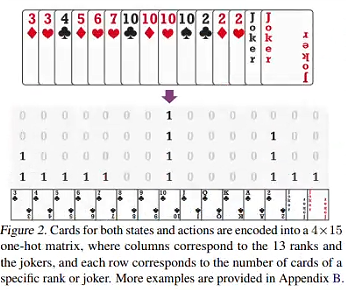

Sample Represent

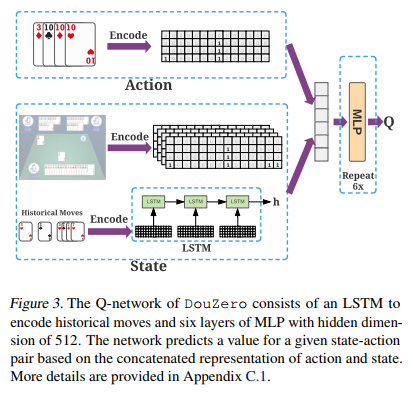

Q-Net

DouZero+

对手建模,对对手手牌的情况进行估计,确定对手手牌的近似概率分布。背后直觉是人类玩家会尝试预测对手卡牌来帮助他们自己做策略。由于斗地主的复杂性,在做决策时,很多行动可能是合适的。在这种情况下,分析对手的手牌将是非常重要的,因为掌握了这个信息,可以帮助智能体选择最佳的动作。

教练指导,构建一个新型的教练网络来选择是否进行对局,使模型可以从更有价值的数据中进行学习,而避免浪费时间。背后直觉是斗地主的结果很大程度上依赖于自身的手牌,如果一个玩家在一开始就获得了很强大的手牌,只要他在游戏中不犯错就很难输掉对局,因此智能体很难从这种对局中学到知识。

Method

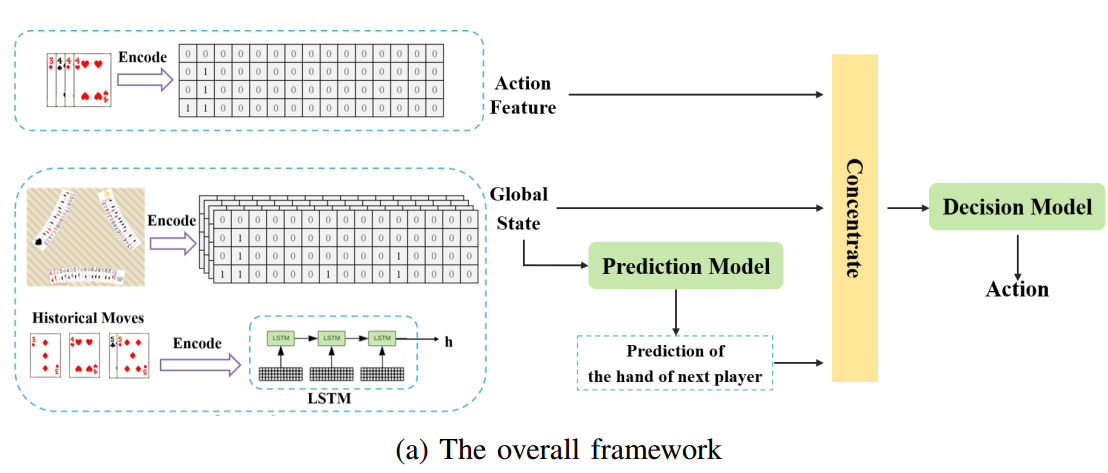

A Opponent Modeling

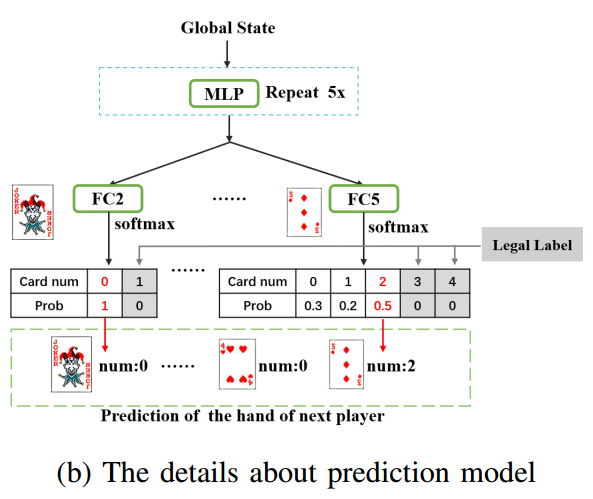

在DouZero框架的基础上加了预测模型,模型的输入是state,输出是下一个玩家手牌的概率。motivation很简单直接:人类玩家对弈的时候一般会猜牌,所以这里会对对手建模。

- (a)Decision Model就是DouZero框架后面那一部分( a = argmax(Q))

- (b)Legal Label是根据局面信息(自己的手牌和已经打出来的牌),据此可以过滤掉不可能的状态

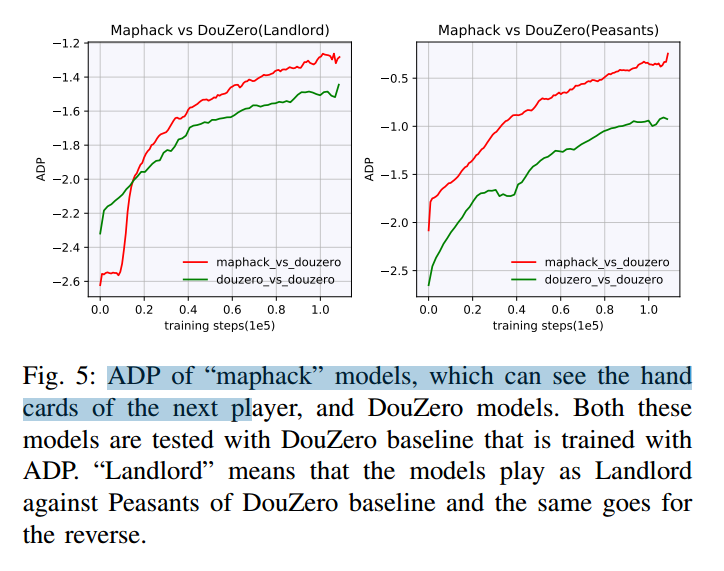

作者首先做了一个预实验,将下一个玩家的手牌直接添加到状态特征中,其结果如图所示。

可以看出,将下一个玩家的手牌加入到状态特征中确实可以提高智能体的表现,尤其是对农民玩家来说。作者认为农民的明显进步是由于了解下一个玩家的手牌不仅可以帮助农民选择地主要不起的手牌,而且还可以帮助农民选择可以更好地配合队友的手牌。而对于地主来说,知道下一个玩家的手牌确实有助于做出决定,但如果手很弱,即使拥有这样的信息也没有很大的帮助。综上所述,本研究的预实验结果表明,引入下一个玩家的手牌的显式表示可以提高斗地主人工智能的性能。(特别是农民角色)

B Coach Network

实验结果

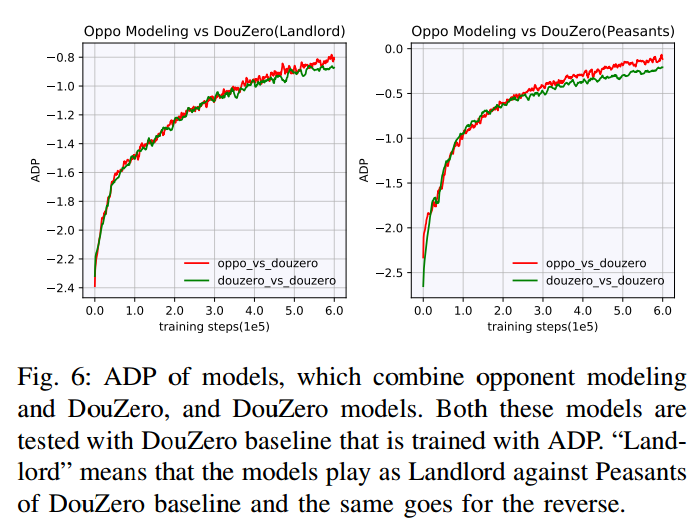

Oppo Modeling

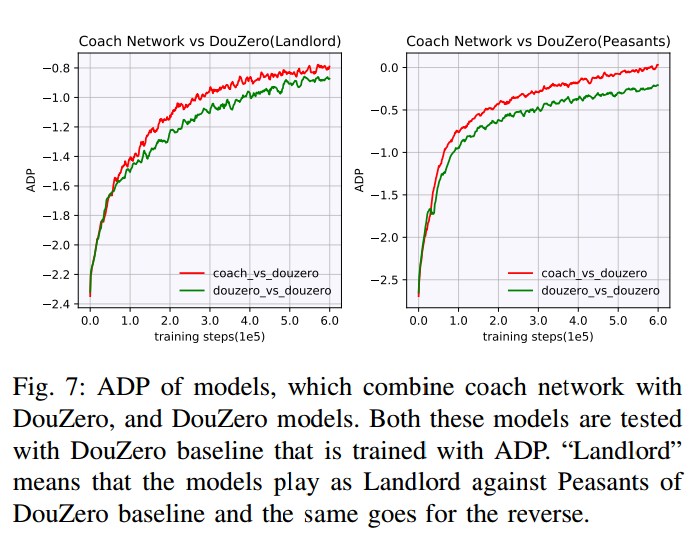

CoachNet

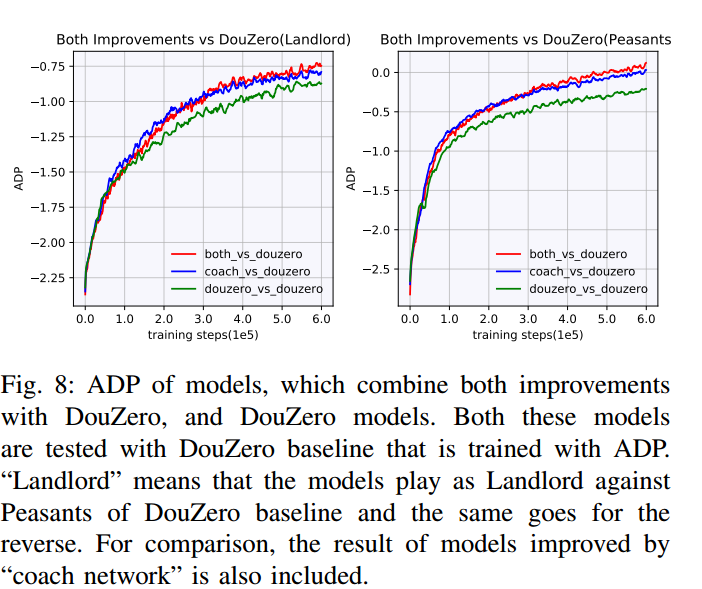

Both方法

ref

【论文阅读】DouZero+: Improving DouDizhu AI by Opponent Modeling and Coach-guided Learning_见见大魔王的博客-CSDN博客